谷歌和MIT合作开发的量子算法可指数加速深度神经网络训练

用于训练广泛和经典神经网络的量子算法已成为量子计算机应用中最有前途的研究领域之一。虽然神经网络在许多基准任务中取得了最先进的结果,但现有的量子神经网络尚未清楚地证明对涉及经典数据集的任务是否具有量子加速。由于深度学习不断在提高计算性能要求,使用量子计算机来有效训练深度神经网络是一个可以从进一步探索中受益的研究领域。

受经典深度神经网络(DNN)成功的启发,由麻省理工学院和Google Quantum AI组成的一个合作团队提出了一种量子算法,旨在以对数时间训练此类神经网络。通过在标准MNIST图像数据集上验证其效率,该团队为他们提出的方法提供了令人信服的证据。

尽管当前用于量子机器学习的大多数算法都是基于线性代数法,神经网络依靠非线性来充当通用的函数逼近器。因此,最近的这项研究引入了神经切线核(NTK),将超参数化神经网络表示为应用于非线性特征的线性化模型。

NTK定义了任意一对数据示例之间的内核,描述了深度神经网络在通过梯度下降训练期间的演变。例如,在无限宽度限制中,使用此内核描述的高斯分布神经网络可以与使用梯度下降训练的神经网络产生相当的结果。

NTK的形式通过增加隐藏层的数量阐明了DNN的好处。随着神经网络的深入,NTK矩阵变得更好,通过梯度下降能加速神经网络的训练。虽然通过梯度下降收敛的NTK有效条件对应于有效量子算法训练神经网络的必要条件,但由于严格的理论警告(例如矩阵稀疏性),现有的量子算法在这方面经常会失败。

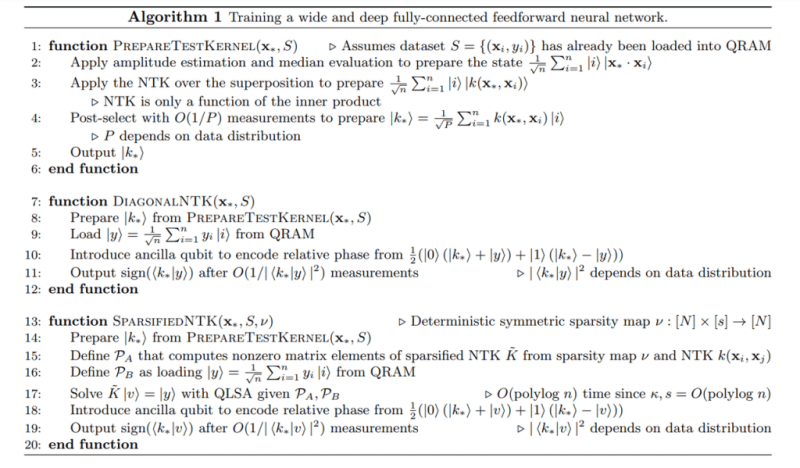

这项工作的主要贡献是开发了一种量子算法,能在近似NTK的情况下训练宽而深的神经网络,随着训练集大小的增加,估计训练后的神经网络其输出误差会消失。该团队提供了两种不同的近似值:一种是稀疏的NTK,它只允许任何行或列中的O(log n)个非对角元素为非零;另外一种是对角线NTK,它将NTK的所有非对角线元素设置为零。在这2种情况下,逼近的收敛都是通过NTK的矩阵元素边界完成的,而相同的边界也直接实现了高效的梯度下降。

该团队将他们提出的全量子算法的近似NTK方法总结为:1、假设存在量子随机存取存储器(QRAM)来存储和访问任何必要的量子态;2、使用幅度估计和中值估计来评估数据示例间的内积以计算NTK元素;3、后选准备测试数据点和训练集之间的NTK。

该团队对MNIST二进制图像分类任务进行了实验,以评估他们的这种新方法。实验结果表明,MNIST图像数据集满足高效输入/输出的必要条件,并验证了所提出的量子算法在梯度下降上实现了端到端指数加速的能力。(编译:Qtech)