量子关系知识蒸馏

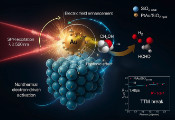

知识蒸馏(KD)是一种被广泛采用的模型压缩技术,可将大型模型压缩为更高效的小型学生模型,从而部署在计算资源有限的设备上。在各类KD方法中,关系型知识蒸馏(RKD)通过对齐特征空间中的关系结构(如样本间距离和角度)来提升学生模型性能。本研究提出量子关系型知识蒸馏(QRKD),通过引入量子关系信息扩展了RKD框架。具体而言,该工作将经典特征映射至希尔伯特空间,将其解释为量子态,并通过计算量子核值来捕获更丰富的样本间关系。这些量子启发的关联信息随后被用于指导蒸馏过程。该团队在视觉和语言任务(包括MNIST和CIFAR-10数据集上的CNN模型,以及WikiText-2、宾州树库和IMDB数据集上的GPT-2模型)上评估QRKD。在所有基准测试中,相比经典RKD方法,QRKD均能持续提升学生模型性能。值得注意的是,师生模型始终保持经典架构,可部署于标准硬件设备,仅训练阶段需要量子计算支持。这项研究首次在完全经典部署场景下实现了量子增强的知识蒸馏技术实证。