量子知识蒸馏用于大型语言模型

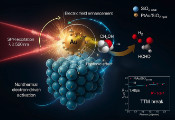

大语言模型(LLMs)在推动自然语言处理领域的发展中扮演着至关重要的角色,广泛应用于从机器翻译到内容创作的多个领域。然而,随着这些模型的规模扩展到数十亿参数,其对资源的需求也急剧增加。与此同时,量子计算因其能够利用叠加和纠缠等量子特性高效解决复杂问题而备受关注,为解决这些挑战提供了新的思路。该工作尝试将量子计算与LLMs相结合,提出了一种面向LLMs的量子知识蒸馏算法(QD-LLM),旨在减少模型加载和推理所需的计算和内存开销。具体而言,在蒸馏阶段,数据同时输入到LLMs和设计的量子学生模型中,以初步量化两者输出之间的差异;随后,在真实标签的辅助下,执行量子学生模型的优化,以最小化其与LLM输出之间的差异。在整个过程中,仅更新量子学生网络的参数,使其输出更接近LLMs,从而实现蒸馏的目的。最终,通过QD-LLM获得的优化学生模型能够在推理阶段高效解决特定领域任务,而无需使用原始LLMs。实验结果表明,与主流压缩方法相比,QD-LLM在保持性能的同时,显著减少了训练参数数量、内存消耗、训练时间和推理时间。此外,通过QD-LLM获得的优化学生模型在特定任务上超越了专门设计的模型。研究团队认为,QD-LLM可以为探索量子计算在模型压缩中的应用奠定基础,并有望扩展到其他自然语言处理挑战中。